Temas

análisis

(9)

Características de los medios audiovisuales

(7)

el sonido

(9)

publicidad

(20)

radio televisión web

(5)

4 feb 2022

10 abr 2021

By plastibarrows on 3:52

Posted in el sonido, Géneros musicales en publicidad, publicidad | No comments

22 nov 2020

11 nov 2020

29 oct 2020

By plastibarrows on 17:04

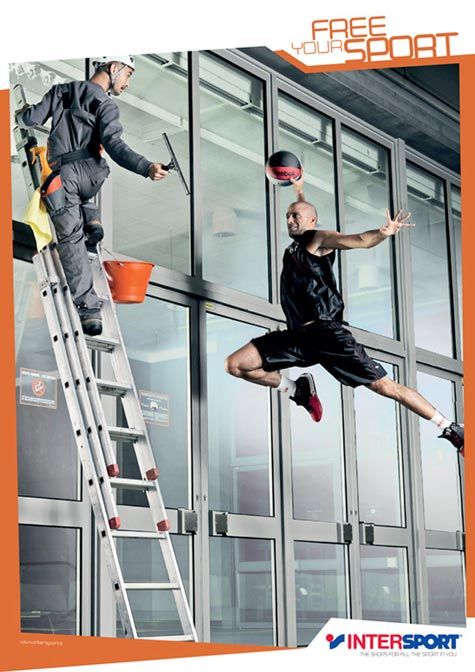

Son el medio que nos permite relacionar unas partes con otras dentro de la composición, nos indican su lectura imponiendonos un recorrido visual y guiándonos hasta el punto de mayor interés visual.

Tipos de direcciones:

- Direcciones de escena:

- Representadas: cuando existen elementos visuales que marcan gráficamente esas direcciones (brazos o dedos extendidos, objetos con punta)

- Inducidas: cuando no existe un elemento real que nos guíe a la dirección pero existen otros elementos como miradas, dos elementos que tengan el mismo color o la misma forma, hacen que los unamos visualmente.

- Direcciones de lectura: indican la manera en la que debe leerse una imagen para obtener el máximo de significado posible.Las direcciones de lectura, nos van a sugerir unas sensaciones u otras.

- Por ejemplo: una dirección de lectura con lineas curvas, sugerirá una sensación de calma, sensualidad, agrado.

- Una lectura en la que pasemos de un sitio a otro a través de lineas compositivas más quebradas, dará sensación de movimiento, vitalidad, violencia...

- la dirección vertical es más impactante que la horizontal

Posted in análisis, composición | No comments

21 oct 2020

10 oct 2020

Suscribirse a:

Entradas (Atom)

BuScas alGo

agencia publicitaria

análisis

análisis de spot pautas

angulaciones

anuncios interactivos

audiencias

AudioBranding

audiómetros

bandas sonoras

Bill Viola

Briefing

Buzz Track

campaña publicitaria

campañas humanitarias

CARACTERÍSTICAS DE LA PRODUCCIÓN AUDIOVISUAL

características de la radio y televisión

Características de los medios audiovisuales

caracteristicas del sonido

códigos QR

collage

composición

contrapublicidad

contrastando imágenes

creativos

efectos en el cine

el color en los medios audiovisuales

el sonido

elementos expresivos y compositivos de la imagen en movimiento

estereotipos

estereotipos dados la vuelta

estereotipos que no nos representan

estudio general de medios

evolución de la música en el cine

flahback

flashforward

Formatos de Audio Digital

fotógrafa´fotografía

funciones de la PUBlicidad

funciones del texto en imágenes publicitarias

géneros

géneros cinematográficos

Géneros musicales en publicidad

GReenWHashinG

ilustración y publicidad

imagen en movimiento primeros pasos

inicio de los gags en el cine

internet y la socialización de la información

Joana Biarnes

Juan Corrales

Ken Jacobs

la luz

la televisión

Leo Burnett

Loreal

Loving Vincent

Medios de comunicación de libre acceso

Medios y Canales de comunicación

movimientos de cámara

musica en el cine

musica en la publicidad

nacimiento del cine

Noam Chomsky

organigrama funciones en una producción audiovisual

planos

poder de la tv

Poesía Visual

Programa CUA

programación en radio y televisión

publicidad

publicidad 8 marzo

publicidad antigua

publicidad asociativa

publicidad de guerrilla

publicidad día de la madre

PUBLICIDAD DIGITAL TIPOS

publicidad emplazada

publicidad social

publicidad subliminal

PUBLICIDAD Y PROPAGANDA

racord

radio interctiva

radio televisión web

radio tipos

radio y publicidad

Radio y Televisión

Recursos en la PUBLicidad

Room tone

Sonido Ambiente

sonido de la publicidad

Sonidos Foley

stop motion

sugestión de la televisión

televisión publica privada y de pago

Tipografía

tipologías en publicidad

Tipos de emisoras

Toni Segarra

trucos de cine

tv tipos

Ugurgallen

Video arte

web 1.0

web 4.0

web1.5

web2.0. web3.0

Wildtrack

EncUEntra por FeCha

DOnde EStá

agencia publicitaria

(1)

análisis

(9)

análisis de spot pautas

(1)

angulaciones

(1)

anuncios interactivos

(1)

audiencias

(1)

AudioBranding

(1)

audiómetros

(1)

bandas sonoras

(1)

Bill Viola

(1)

Briefing

(1)

Buzz Track

(1)

campaña publicitaria

(3)

campañas humanitarias

(1)

CARACTERÍSTICAS DE LA PRODUCCIÓN AUDIOVISUAL

(1)

características de la radio y televisión

(1)

Características de los medios audiovisuales

(7)

caracteristicas del sonido

(1)

códigos QR

(1)

collage

(1)

composición

(1)

contrapublicidad

(2)

contrastando imágenes

(1)

creativos

(1)

efectos en el cine

(1)

el color en los medios audiovisuales

(1)

el sonido

(9)

elementos expresivos y compositivos de la imagen en movimiento

(1)

estereotipos

(1)

estereotipos dados la vuelta

(1)

estereotipos que no nos representan

(1)

estudio general de medios

(1)

evolución de la música en el cine

(2)

flahback

(1)

flashforward

(1)

Formatos de Audio Digital

(1)

fotógrafa´fotografía

(1)

funciones de la PUBlicidad

(1)

funciones del texto en imágenes publicitarias

(1)

géneros

(1)

géneros cinematográficos

(1)

Géneros musicales en publicidad

(1)

GReenWHashinG

(1)

ilustración y publicidad

(1)

imagen en movimiento primeros pasos

(1)

inicio de los gags en el cine

(1)

internet y la socialización de la información

(1)

Joana Biarnes

(1)

Juan Corrales

(1)

Ken Jacobs

(1)

la luz

(1)

la televisión

(1)

Leo Burnett

(1)

Loreal

(1)

Loving Vincent

(1)

Medios de comunicación de libre acceso

(1)

Medios y Canales de comunicación

(1)

movimientos de cámara

(1)

musica en el cine

(1)

musica en la publicidad

(1)

nacimiento del cine

(1)

Noam Chomsky

(1)

organigrama funciones en una producción audiovisual

(1)

planos

(1)

poder de la tv

(1)

Poesía Visual

(1)

Programa CUA

(1)

programación en radio y televisión

(2)

publicidad

(20)

publicidad 8 marzo

(1)

publicidad antigua

(1)

publicidad asociativa

(1)

publicidad de guerrilla

(1)

publicidad día de la madre

(1)

PUBLICIDAD DIGITAL TIPOS

(1)

publicidad emplazada

(1)

publicidad social

(1)

publicidad subliminal

(1)

PUBLICIDAD Y PROPAGANDA

(2)

racord

(1)

radio interctiva

(1)

radio televisión web

(5)

radio tipos

(1)

radio y publicidad

(1)

Radio y Televisión

(2)

Recursos en la PUBLicidad

(1)

Room tone

(1)

Sonido Ambiente

(1)

sonido de la publicidad

(1)

Sonidos Foley

(1)

stop motion

(1)

sugestión de la televisión

(1)

televisión publica privada y de pago

(1)

Tipografía

(1)

tipologías en publicidad

(1)

Tipos de emisoras

(2)

Toni Segarra

(1)

trucos de cine

(1)

tv tipos

(1)

Ugurgallen

(1)

Video arte

(2)

web 1.0

(1)

web 4.0

(1)

web1.5

(1)

web2.0. web3.0

(1)

Wildtrack

(1)